Dando continuidade ao artigo: Ambiente para rodar o Spark

com Scala na IDE do Eclipse (link: https://slothbigdata.blogspot.com/2019/07/ambiente-para-rodar-o-spark-com-scala.html),

no qual preparamos o Eclipse para executar os processos do Spark no Windows

utilizando a linguagem Scala.

Efetuaremos o mesmo processo nesse post, mas

utilizando o Spark, programando em Python dentro da IDE do Pycharm. Assim será possível

executar os seus próprios modelos, sem a necessidade de utilizar um cluster ou

uma VM com a distribuição do Big Data.

1 – Instalação do Java

Primeiro passo é efetuar a instalação da JVM do Java para

rodar os pacotes do Spark. No caso abaixo vamos aproveitar e instalar o pacote

de desenvolvimento do Java (JDK).

Efetuar a instalação do JDK e definir as variáveis de

ambiente no Windows.

Criar a variável do JAVA_HOME no diretório no qual a

aplicação foi instalada.

Editando a variável Path,

insira o caminho do executável do Java.

%JAVA_HOME%\bin

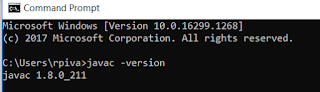

Para teste executar o teste, efetue o comando no Prompt do

Windows:

javac -version

2 – Instalação do Python

Para a instalação do Python vamos utilizar uma versão do

Anconda, que já vem carregada de bibliotecas matemáticas.

Selecione a opção “Windows”, baixe o executável, efetue a instalação com os passos requeridos.

Após a instalação acesse as variáveis de ambiente e insira

o caminho do Python na variável Path do mesmo modo que foi configurado o Java

acima.

Comum o ambiente do Anaconda está configurado nesse caminho:

C:\Users\meuusuario\AppData\Local\Continuum\anaconda3

Para o teste acesso o Prompt e execute o comando:

python –version

3 – Preparando o ambiente do Hadoop no Windows:

Revendo o artigo: Ambiente para rodar o Spark com Scala na

IDE do Eclipse (link: https://slothbigdata.blogspot.com/2019/07/ambiente-para-rodar-o-spark-com-scala.html),

devem executar o processo de implantação do WinUtils no Windows. O arquivo pode

ser baixado no link: https://github.com/slothbigdata/SlothBigDataSparkLicao.

Ao baixar o arquivo e descompacta-lo, novamente devemos

definir a variável de ambiente HADOOP_HOME, para o caminho do diretório.

Insira a nova variável no Path:

%HADOOP%\bin

4 – Instalação das bibliotecas do Spark.

Efetuar o download do arquivo:

Descompactar o arquivo no diretório C:

Visão do diretório:

Entrar no

command line do Windows.

Acessar o diretório: C:\spark-2.4.3-bin-hadoop2.7\bin

Digitar: pyspark

Após a instalação conseguiremos utilizar o Spark pelo Prompt

de Comando do Windows.

5 – Utilizando o desenvolvimento no Pycharm.

Agora configuraremos o Spark para rodar no PyCharm, para

isso temos que configurar mais variáveis de ambiente. Agora vamos inserir o

SPARK_HOME, com o caminho do pacote do Spark que baixamos acima.

C:\spark-2.4.3-bin-hadoop2.7

Incluir no

Path: %SPARK_HOME%\bin

Para teste, execute o pyspark no prompt em qualquer local.

Abaixe a IDE do PyCharm no site: https://www.jetbrains.com/pycharm/

Após a instalação do Pycharm crie um novo projeto. Clicando

na versão do Python, vamos selecionar Interpret Settings -> Project Structure

Clique em Add Content Root:

Adicione o diretório do Python:

C:\spark-2.4.3-bin-hadoop2.7\python

Adicione o py4j-0.9-src.zip no diretório:

C:\spark-2.4.3-bin-hadoop2.7\python\lib\

py4j-0.10.7-src.zip

Após essas configurações, reinicie o PyCharm e o Spark esta pronto para rodar na

IDE.

Fontes:

Em caso de dúvidas ou sugestões, escreva nos comentários ou nos mande um email: slothbigdata@gmail.com.

Nenhum comentário:

Postar um comentário